官公庁AI導入失敗事例に学ぶ

なぜ善意のプロジェクトは失敗するのか? 生成AI導入の課題を探る

Deep Research with Google Gemini 2.5 Proによる調査報告

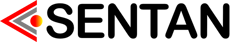

国内官公庁における生成AI導入概況

生成AIの導入は都道府県や指定都市で先行する一方、市区町村では遅れが見られます。この導入格差は、利用可能なリソース(予算、人材)の違いを反映しています。

出典:総務省発表データ(令和6年3月31日時点)

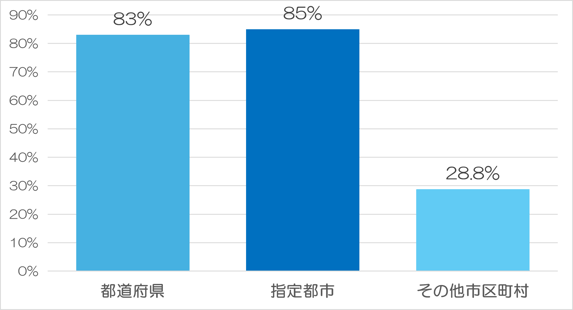

導入を阻む「4つの壁」

多くの官公庁が共通の課題に直面しています。特に「人材不足」が技術的な懸念を上回り、最大の課題として認識され始めています。グラフの項目をクリックすると詳細が表示されます。

導入における主な課題(団体数)

人材不足

AIプロジェクトを企画・推進・評価できる専門知識を持つ職員が不足。外部委託に依存しがちになり、持続的な運用が困難になる。

正確性への懸念

AIが事実に基づかない情報(ハルシネーション)を生成するリスク。特に住民向けサービスでの誤情報は行政への信頼を損なうため、導入の大きな障壁となる。

導入効果が不明

「業務時間XX%削減」のような明確な費用対効果(ROI)を示しにくく、予算確保の説得材料に欠ける。

コスト確保困難

初期導入費用に加え、ライセンス料などの継続的な運用コストが発生。厳しい財政状況の中で、予算の確保が難しい。

ケーススタディ:2つの失敗事例

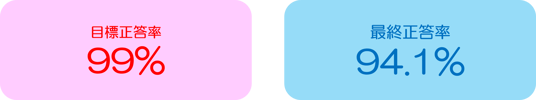

ケース1:三豊市「ごみ分別AIチャットボット」PoC中止

市民サービス向上を目指したが、AIの精度が目標に届かず、職員の負担も軽減できないと判断され、本格導入には至りませんでした。

中止の主な要因:

・情報の絶対的な正確性が求められる業務で、AIの誤りを許容できなかった。

・AIの回答を職員が全件確認する必要があり「負担軽減」に繋がらなかった。

・曖昧な回答が多く、最終的に有人対応が必要となり、利便性向上が限定的だった。

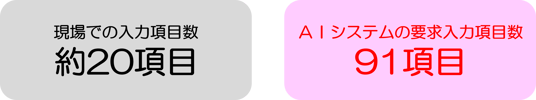

ケース2:こども家庭庁「虐待リスク判断AI」開発頓挫

児童相談所職員の負担軽減が目的でしたが、現場の業務実態を無視したシステム設計が原因で、計画そのものが頓挫しました。

失敗の構造分析

AI導入の失敗は単一の原因ではなく、複数の要因が複雑に絡み合って発生します。ここでは、失敗の構造を4つの側面に分類して分析します。

1. 技術的要因

精度の限界:ハルシネーション(AIの嘘)は不可避であり、行政の求める「100%の正確性」と根本的にミスマッチ。

RAGの課題:参照させる庁内データの品質が低いと、AIの回答品質も低下する。

2. 運用的要因

データ品質:サイロ化され、形式が不統一なデータではAIは性能を発揮できない。

人材不足:AIを使いこなし、プロジェクトを管理できる専門人材が圧倒的に不足。

現場の抵抗:現場の業務を理解しないシステムは、使われずに形骸化する。

3. 組織的・制度的要因

旧来の調達:変化の速いAI技術と、仕様固定型の従来の調達プロセスが合わない。

リスク管理の不備:倫理や情報漏洩に関するリスク管理体制が追いついていない。

縦割り行政:部署ごとの試行錯誤が共有されず、組織的な学びが生まれない「PoCの罠」。

4. 期待値管理の失敗

過度な期待:「AIなら何でもできる」という誤解が、導入後の「期待外れ」に繋がる。

コミュニケーション不足:開発者、利用者、管理職の間での目的や限界に関する認識のズレ。

成功への6つの提言

1. 目的の明確化

「流行りだから」ではなく「何を解決したいか」を定義する。リスクの低い内部業務からスモールスタートする。

2. 徹底したPoC

技術検証だけでなく、業務適合性や費用対効果を厳しく評価。「小さく失敗し、学ぶ」文化を醸成する。

3. データガバナンス強化

AI導入はデータ整備から。庁内データの品質向上と一元管理体制を構築する。

4. 人材育成と確保

全職員のAIリテラシー向上と、プロジェクトを牽引する専門人材の確保を両輪で進める。

5. 利用者中心の設計

開発初期から現場職員を巻き込み、真のニーズを反映した、本当に「使える」システムを作る。

6. リスクと倫理への配慮

バイアスや情報漏洩、著作権等のリスクを管理し、判断の透明性を確保する「責任あるAI」を目指す。